国内AI公司DeepSeek发布了其最新开源大语言模型 DeepSeek-V3。作为一款基于自研架构的超大规模开源模型,V3的表现不仅在国内开源领域中处于领先地位,还在部分任务上接近国际顶尖闭源模型(如GPT-4o和Claude-3.5-Sonnet)。

模型特点:参数规模与架构设计

DeepSeek-V3采用了 混合专家(MoE)架构,拥有 6710亿参数,但在推理时只激活 370亿参数。这一设计在保证模型性能的同时,显著提升了计算效率。相比之下,其前代产品DeepSeek-V2拥有2360亿总参数,激活参数为21亿,V3在规模和性能上均有较大提升。

这样的架构设计,使得V3能够在高效运行的同时,保持对复杂任务的良好适应能力。

性能表现:稳步接近闭源模型

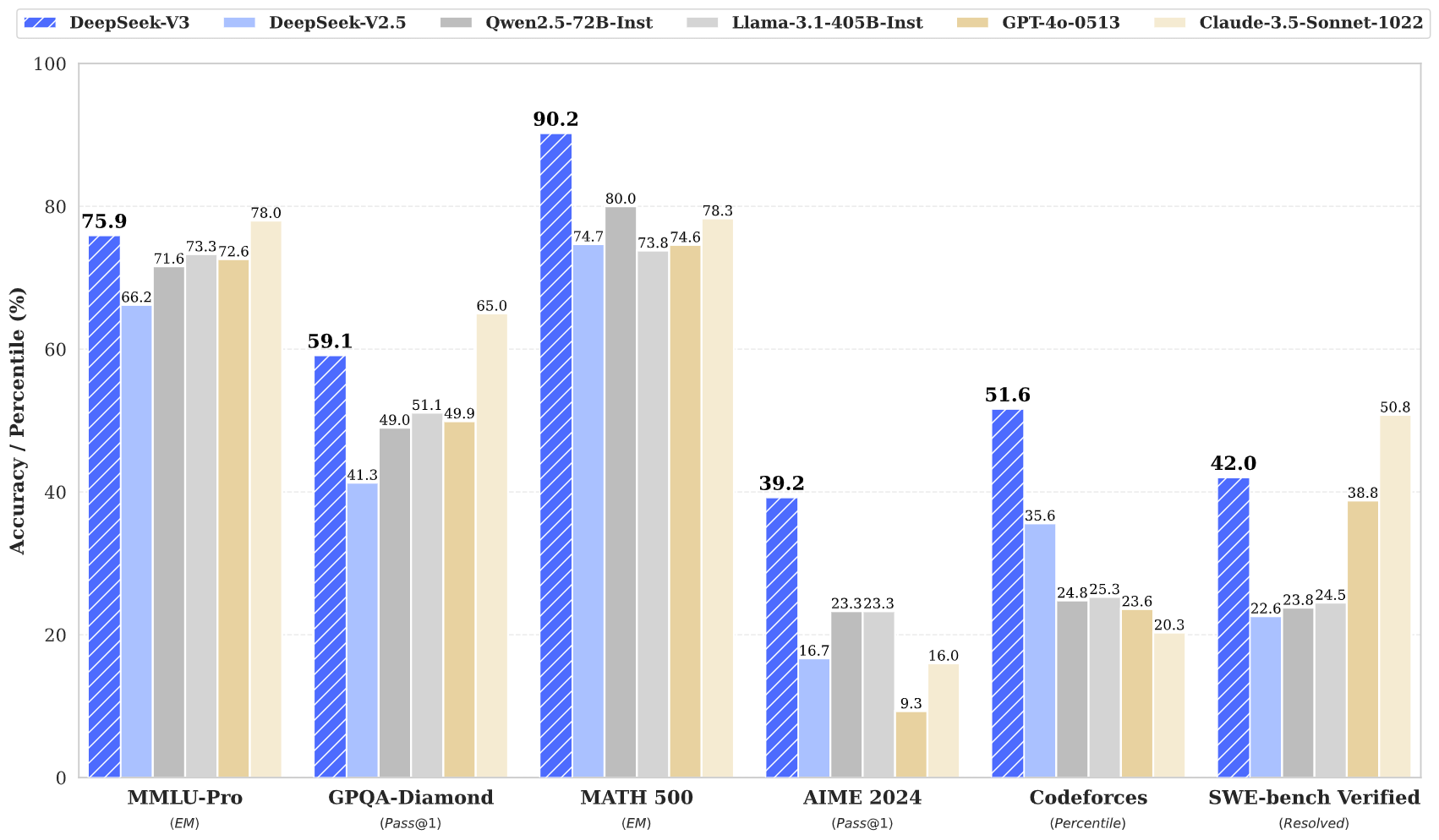

根据DeepSeek的测试,DeepSeek-V3在多项基准任务中表现优异,尤其是在中文任务、数学推理和代码生成等领域。在数学测试(MATH 500)中,V3的得分为90.2%,在编程相关的Codeforces和SWE测试中也取得了较高成绩。

在与开源模型(如Llama-3.1和Qwen 2.5)对比中,V3展现了明显优势;而在与国际主流闭源模型(如GPT-4o、Claude-3.5)对比时,V3虽然在部分任务上仍有差距,但整体表现已相当接近,尤其是在中文语言领域中具有竞争力。

速度提升:推理效率显著增强

DeepSeek-V3在推理速度上也有较大进步。生成速度从前代产品的 20 TPS(每秒生成20个token) 提升至 60 TPS,达到了前代的三倍。这一改进为开发者和用户提供了更高效的使用体验,特别是在需要生成长文本或快速响应的场景中表现突出。

开源与API服务:强调普惠性

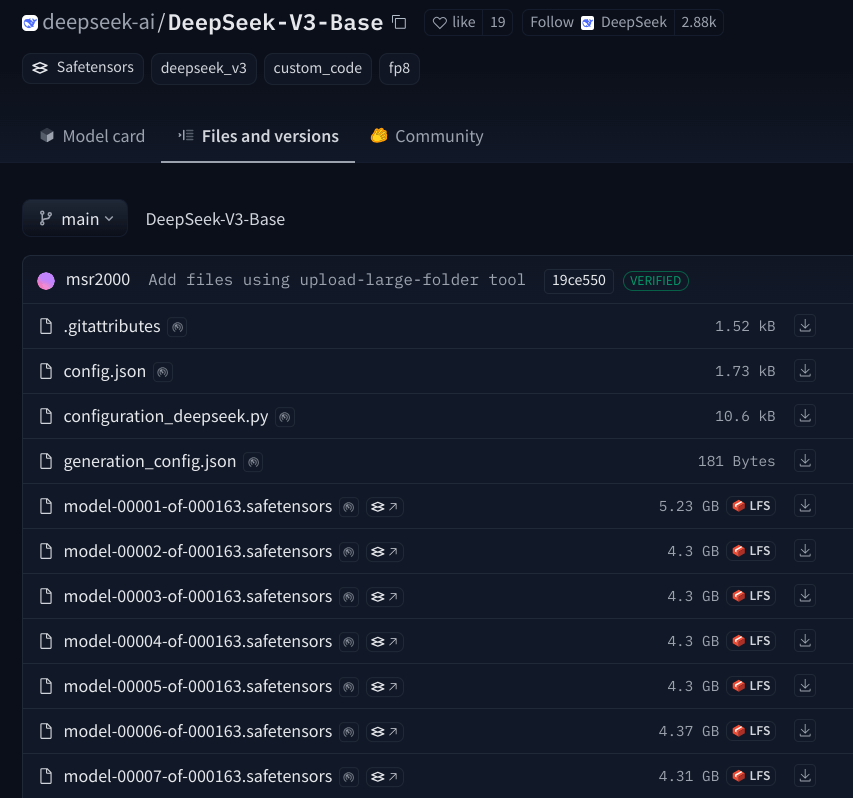

DeepSeek-V3已在GitHub上同步开源,用户可以直接访问相关代码并进行本地测试。同时,DeepSeek提供了API服务,定价如下:

输入tokens:缓存命中 0.5元/百万,缓存未命中 2元/百万

输出tokens:8元/百万

DeepSeek还为新API服务设定了 45天优惠体验期,以帮助用户在低成本下体验和测试新模型。

训练过程:成本控制与技术优化并行

在训练DeepSeek-V3时,团队采用了 FP8混合精度训练 等技术优化手段。在硬件资源方面,训练使用了总计 2000块H800 GPU,训练数据量达到 14.8万亿tokens。整个训练过程耗时278.8万GPU小时,成本约为 557万美元。

与国际其他超大规模模型相比(如GPT-4动辄数亿美元的训练成本),DeepSeek-V3在训练成本上的控制较为突出。

社区反响:褒贬不一

DeepSeek-V3的发布在社区内引发了较多讨论。一方面,其性能和开源的透明性受到肯定,部分开发者认为它进一步缩小了国内开源AI与国际顶尖水平之间的差距;另一方面,也有用户对API接口的调整提出了质疑,认为接口变化在短期内增加了适配成本。

未来计划:迈向通用人工智能(AGI)

DeepSeek表示,V3的发布是公司发展中的一个重要阶段,未来计划在以下方向继续探索:

突破Transformer架构限制:开发支持更大上下文长度的模型,进一步提升模型的推理能力和适用场景。

逐步迈向通用人工智能(AGI):以开源为核心,推动AI模型在多领域的泛化能力。