ControlNeXt是一种新型的可控生成方法,由香港中文大学和商汤科技的研究团队开发,可解决当前可控生成方法如ControlNet在计算资源、训练难度和控制效果方面的问题,为AI生成模型带来了更高效、更灵活的控制能力。

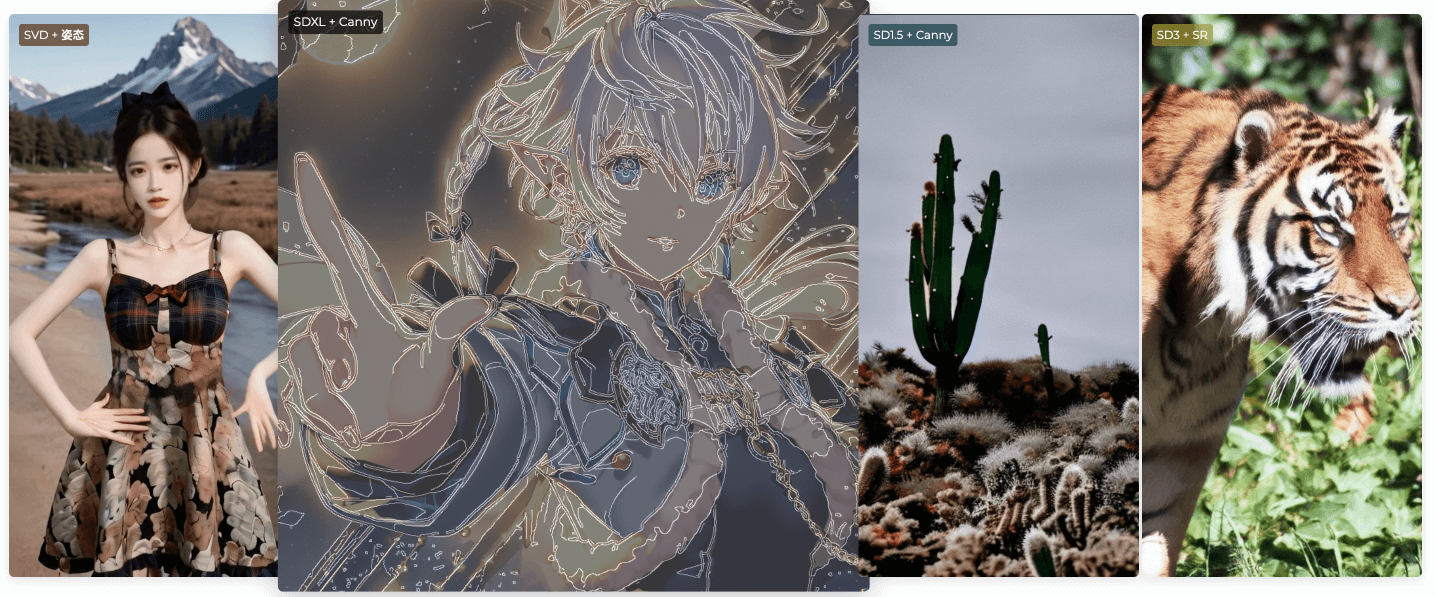

简而言之,ControlNeXt为多种主流基础模型(如SD1.5、SDXL、SD3和SVD)提供了一个轻量级的控制模块,显著提升了图像和视频生成任务的效率和质量。

ControlNeXt的关键优势包括:

架构优化:相比前代技术ControlNet,ControlNeXt采用了更为精简的结构,大幅降低了计算开销。

参数效率:通过创新设计,ControlNeXt减少了高达90%的可训练参数,极大地提高了训练效率。

训练加速:引入的交叉归一化(Cross Normalization)技术取代了传统的"零卷积",实现了更快速、更稳定的训练过程。

灵活适应:ControlNeXt能够无缝集成其他LoRA权重,轻松实现风格转换,无需额外训练。

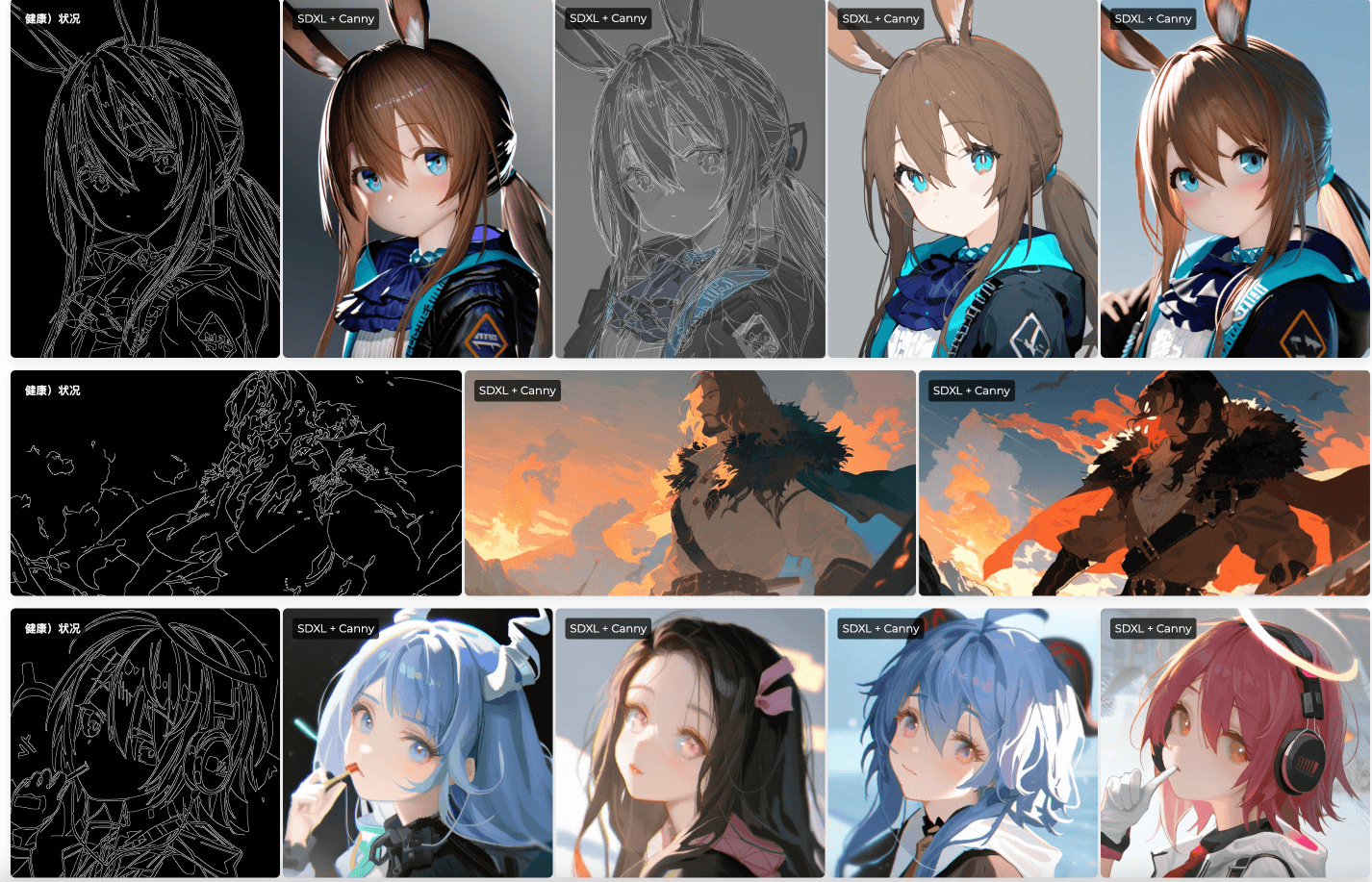

广泛兼容:支持多种控制信号(如人体姿态、边缘图、线条图等)和多个基础模型,展现了出色的通用性。

ControlNeXt模型系列:

ControlNeXt-SDXL:基于Stable Diffusion XL的可控图像生成模型。

ControlNeXt-SVD-v2:基于Stable Video Diffusion的视频生成模型,通过人体姿态序列控制生成过程。相比v1版本,在训练数据质量、批处理帧数、生成分辨率等方面都有提升。

ControlNeXt-SVD:v1版本的视频生成模型,可视为AnimateAnyone的一种实现尝试。

ControlNeXt-SD1.5:基于Stable Diffusion 1.5的可控图像生成模型。

ControlNeXt-SD3:即将推出的模型。

ControlNeXt的创新之处在于它在保持强大控制能力的同时,显著提升了模型的效率和灵活性。它不仅减少了计算资源需求,还提供了更快的训练速度和更稳定的输出结果。

该项目目前仍在持续演进。研究团队承诺将不断更新代码和模型,以提供更多功能和更优秀的性能。