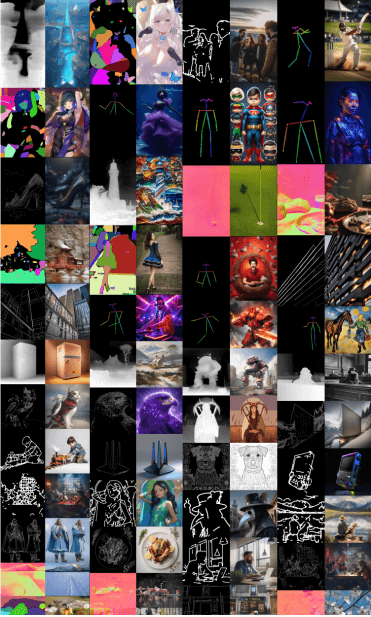

ControlNet Union SDXL 1.0是由xinsir开源的ControlNet整合模型,与此前需要针对不同任务下载和使用多个ControlNet模型的做法不同,ControlNet Union将姿势估计、深度图、边缘检测等十余种常用的图像控制功能巧妙融合到单一模型之中。用户无需在不同模型间反复切换,即可轻松实现多样化的图像处理需求,大大简化了操作步骤,提高了工作效率。

ControlNet Union的核心优势

多功能性:这个单一模型支持10多种控制条件,包括姿势估计、深度图、边缘检测等,无需切换不同模型。

高质量输出:通过先进的训练技术,如桶训练和大规模高质量数据集(超过1000万图像),该模型能生成各种宽高比的高分辨率图像。

智能提示:利用CogVLM生成详细的图像描述,大大提高了模型对提示的理解和执行能力。

多条件融合:支持多种控制条件的组合使用,条件融合在训练过程中自动学习,无需手动调参。

兼容性强:与其他开源SDXL模型和LoRA模型兼容,扩展了其应用范围。

如何使用ControlNet Union

下载模型:

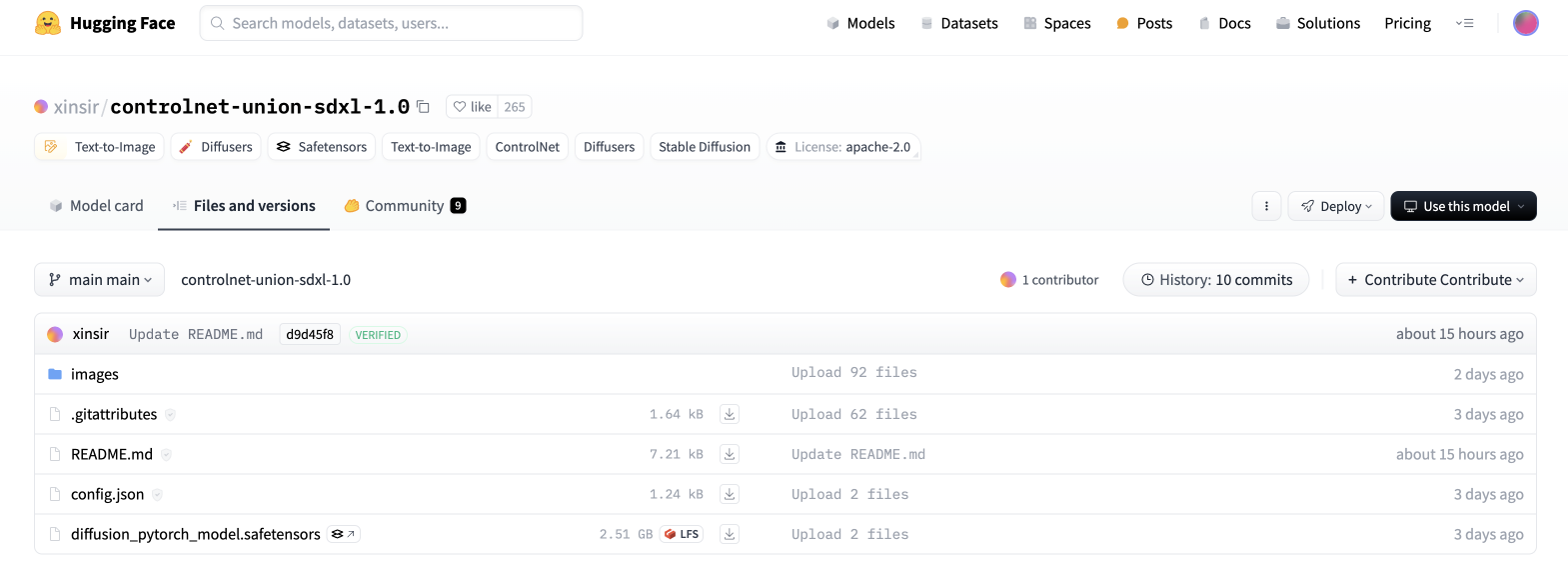

![iShot_2024-07-10_14.07.35.png iShot_2024-07-10_14.07.35.png]()

访问Hugging Face页面(https://huggingface.co/xinsir/controlnet-union-sdxl-1.0)

在"Files and versions"部分下载diffusion pytorch模型文件(约2.51GB)

安装模型:

将下载的文件放入Automatic1111或ComfyUI的models/controlnet文件夹中

在ComfyUI中使用:

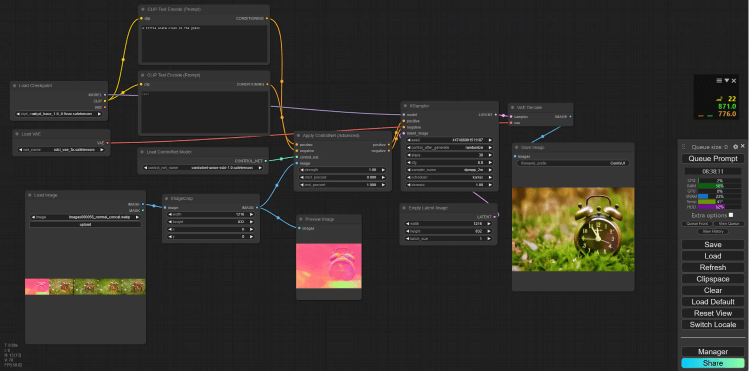

![ControlNet Union丨多种ControlNet无缝整合_3.png ControlNet Union丨多种ControlNet无缝整合_3.png]()

创建一个简单的文本到图像工作流

使用"Load Control Net Model"节点加载ControlNet Union模型

使用"Control Net Preprocessor"节点(来自ComfyUI Art Venture包)处理输入图像

选择所需的预处理方法(如scribble、depth map等)和SDXL版本

将预处理后的图像连接到"Apply Control Net"节点

将文本提示的conditioning输入连接到"Apply Control Net"节点

将"Apply Control Net"的输出连接到采样器节点

配置参数:

选择合适的采样器(如DPM++ SDE)和调度器(如Karras)

设置步数、CFG scale等参数

使用空白潜在图像作为输入

生成图像:

运行工作流程,查看ControlNet Union生成的高质量输出图像

ControlNet Union为创意工作者打开了新的可能性。从姿势控制到线稿转换,从深度感知到分割图,这个模型几乎涵盖了所有常见的图像处理需求。ControlNet Union代表了AI图像生成和编辑工具的一个重要进步。它将多种功能整合到一个高效的模型中,而这种整合也将会是后面AI绘图的一种趋势。

https://huggingface.co/xinsir/controlnet-union-sdxl-1.0/tree/main