近年来,人工智能技术在图像生成领域取得了长足进步。以Stable Diffusion、Midjourney等为代表的文本到图像(Text-to-Image)生成模型,让我们见证了机器想象力的惊人表现。然而,当前的图像生成技术仍然存在一些局限性,如生成图像的质量和多样性有待提升,用户难以精准控制生成结果等。

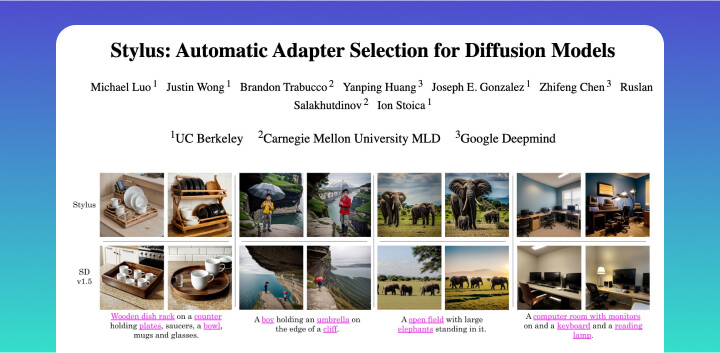

为了进一步推动AI图像生成技术的发展,来自UC Berkeley、CMU和Google Deepmind的研究团队联合推出了一个名为Stylus的全新项目。Stylus旨在通过自动为扩散模型选择最优的Adapter(适配器),来生成更加精美、创意十足、量身定制的图像。

Adapter是在预训练好的扩散模型基础上,针对特定领域或风格进行微调获得的轻量级模型。得益于开源社区的贡献,目前已经积累了超过10万个涵盖多种主题和艺术风格的Adapter。然而,海量的Adapter资源也给用户选择和使用带来了困扰,主要问题在于Adapter的描述信息往往不够充分和准确。

Stylus提出了一种创新的三阶段方法来攻克这一难题:

Refiner(提炼器):智能分析每个Adapter的模型卡片,自动生成精炼且准确的描述,并将其编码为嵌入向量。

Retriever(检索器):将用户输入的文本提示编码为向量,快速检索出最相关的K个Adapter。

Composer(组合器):根据提示词的关键词,自动将任务分解并为每个子任务匹配最佳Adapter组合,同时过滤掉无关Adapter以保证图像质量。

借助这一流程,用户只需提供一句简单的文本提示,Stylus就能自动为其生成一张高质量、富有创意且符合要求的图像。

研究团队还构建了一个名为StylusDocs的评估数据集,其中包含7.5万个带有预计算嵌入向量的Adapter。实验结果显示,无论是真实场景还是卡通风格,Stylus生成的图像都比现有的Stable Diffusion模型更受人类评估者青睐(偏好度提升约2倍)。Stylus在文本对齐度、视觉保真度和图像多样性等客观指标上也有明显优势。

假设您是一位插画师,想要创作一张充满童话色彩的图像,主题是"一只穿着蓝白色水手服的可爱小猫,坐在魔法蘑菇丛中,蘑菇上点缀着彩色糖果,背景是梦幻的糖果城堡"。

传统的做法是,您可能需要在Stable Diffusion等扩散模型中尝试多个提示词的组合,并对生成的图像进行筛选和编辑,直到获得满意的结果。这个过程可能需要一定的时间和精力。

而使用Stylus,您只需输入上述的文本提示,Stylus就会自动为您生成一张高质量、符合要求的图像,整个过程可能只需要几秒钟。那么,Stylus是如何实现这一神奇的效果的呢?

首先,Stylus的Refiner模块会分析海量Adapter的信息,找出与"童话"、"小猫"、"水手服"、"蘑菇"、"糖果"、"城堡"等概念最相关的一些Adapter,并生成精炼的描述。这一步可以理解为Stylus在庞大的素材库中,智能地为您挑选出了最有用的"画笔"和"颜料"。

接下来,Retriever模块会将您的文本提示编码为向量,在Adapter库中搜索与之最匹配的若干Adapter。这些Adapter可能分别擅长生成童话风格、小动物形象、糖果元素等。

最后,Composer模块会将您的提示拆分成多个子任务(如小猫、蘑菇、城堡等),并为每个子任务分配最相关的一个或几个Adapter。它们就像一组训练有素的画家,分工合作,共同完成这幅童话插画的创作。Composer还会检查每个Adapter与提示的相关性,剔除可能产生干扰的无关Adapter,确保画面主题的一致性。

所有这些步骤都是自动完成的,您只需提供一句简单的文本提示,Stylus就能将抽象的语言转化为充满想象力和创意的图像。

Stylus的潜在应用前景广泛。对于普通用户而言,Stylus大大降低了使用AI进行艺术创作的门槛。对于专业艺术家和设计师来说,Stylus可以作为一个得力的创作助手,帮助他们快速生成多样化的草图和灵感,提升创作效率