ByteDance公司近日推出了其视觉生成AI新作StoryDiffusion模型,StoryDiffusion是一种基于一致性自注意力和语义运动预测技术的创新生成模型,可以生成风格内容高度一致的图像和视频序列,尤其适用于需要连贯视觉内容来讲述故事情节的场景比如漫画。

它最鲜明的特点就是内容一致性强。通过创新的一致性自注意力机制,StoryDiffusion能有效确保生成的连续图像或视频中,人物形象、服饰风格等元素保持高度统一,避免出现突兀的断裂感,让叙事更加流畅自然。以往的生成技术中,这一痛点一直是行业难题。

除了内容一致性,StoryDiffusion在长视频生成质量方面也有独到之处。传统模型在生成长视频时往往会出现不连贯或跳跃的问题,而StoryDiffusion采用的语义运动预测器能在语义空间精准预测和控制图像间的运动变化,使得生成的长视频更加平滑流畅。

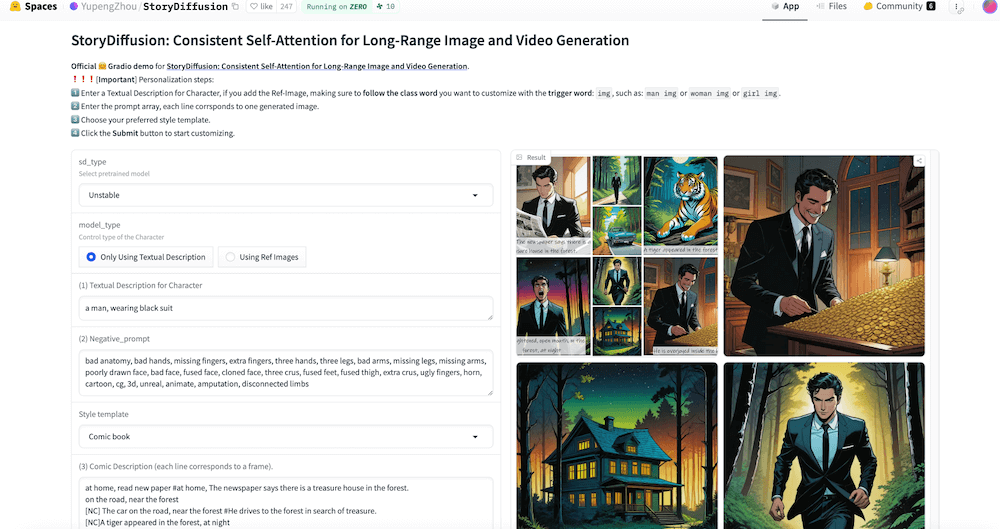

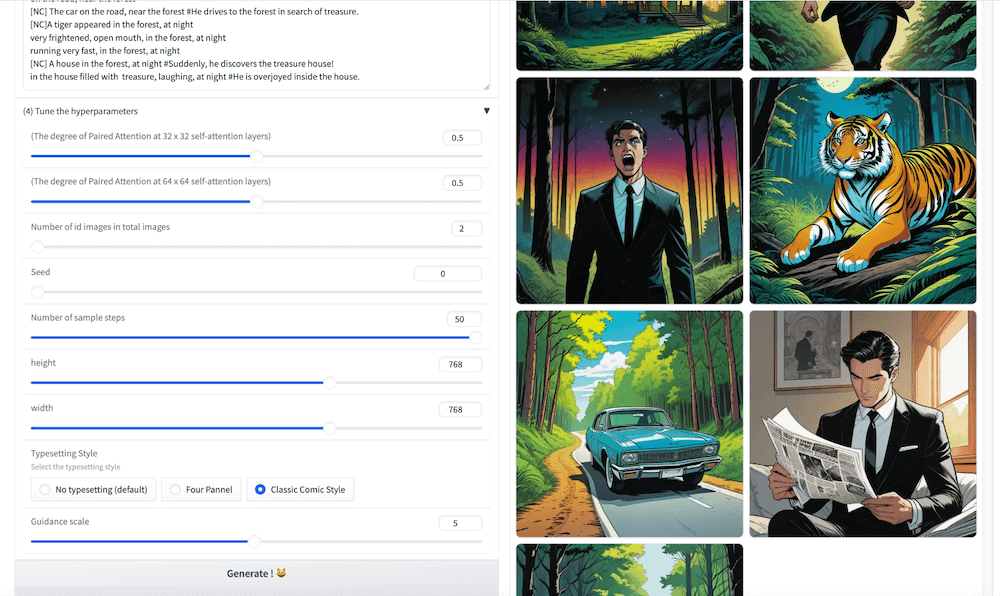

可控性是StoryDiffusion的另一大亮点。用户可通过文本直接控制和引导生成内容,大幅提升了模型的灵活性,既能满足个性化需求,又不失内容的一致性。

这一模型还具备计算高效、扩展性强等优势。它采用了轻量级设计,可在现有硬件上高效运行;同时还可无缝扩展至多图像或视频生成场景,拓展了应用范围,特别适用于需要多幅序列画面的漫画、动画等领域。

设想一个场景:如果你想创作一部科幻探险短片,只需要为StoryDiffusion输入诸如"探险者在丛林中行走"、"发现隐藏的宝藏"这样的文本提示,模型就会为你生成一系列内容连贯、风格统一的高质量图像或视频。

除了长视频内容,StoryDiffusion也很擅长数字漫画创作。你可以逐帧输入文本描述剧情,比如"某人在家中看到一则新闻,说森林里藏有宝藏"、"于是他开车前往森林"、"遇到危险野生动物"、"最终发现宝藏"等等,模型就会为你一气呵成生成高度一致的漫画画面序列。无论角色的面部神情、服装造型,还是背景元素,全部保持风格统一。

现在可在官方提供的在线Demo上体验StoryDiffusion