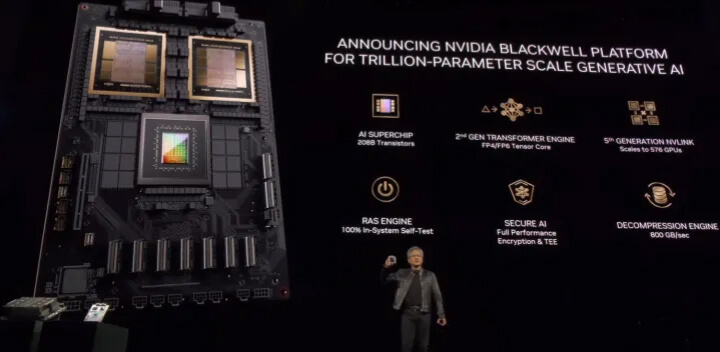

在最新2024 GTC大会上Nvidia带来了重磅消息:全新的 Blackwell GPU 架构横空出世,据称是有史以来最强悍的 AI 芯片。消息一出就引起了不小的轰动,因为 Nvidia 凭借其此前的 H100 芯片已经成为万亿美元市值的公司,甚至有可能超过谷歌和亚马逊。而这次的 Blackwell 系列,可能会让 Nvidia 的优势进一步扩大。

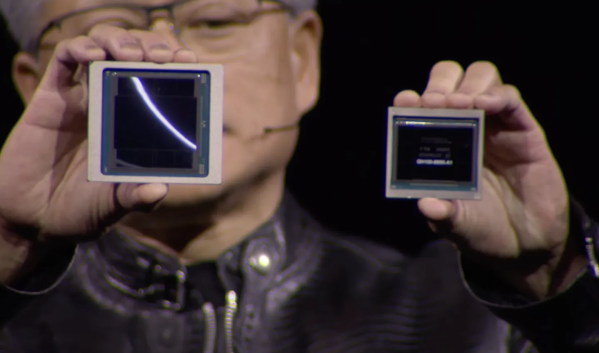

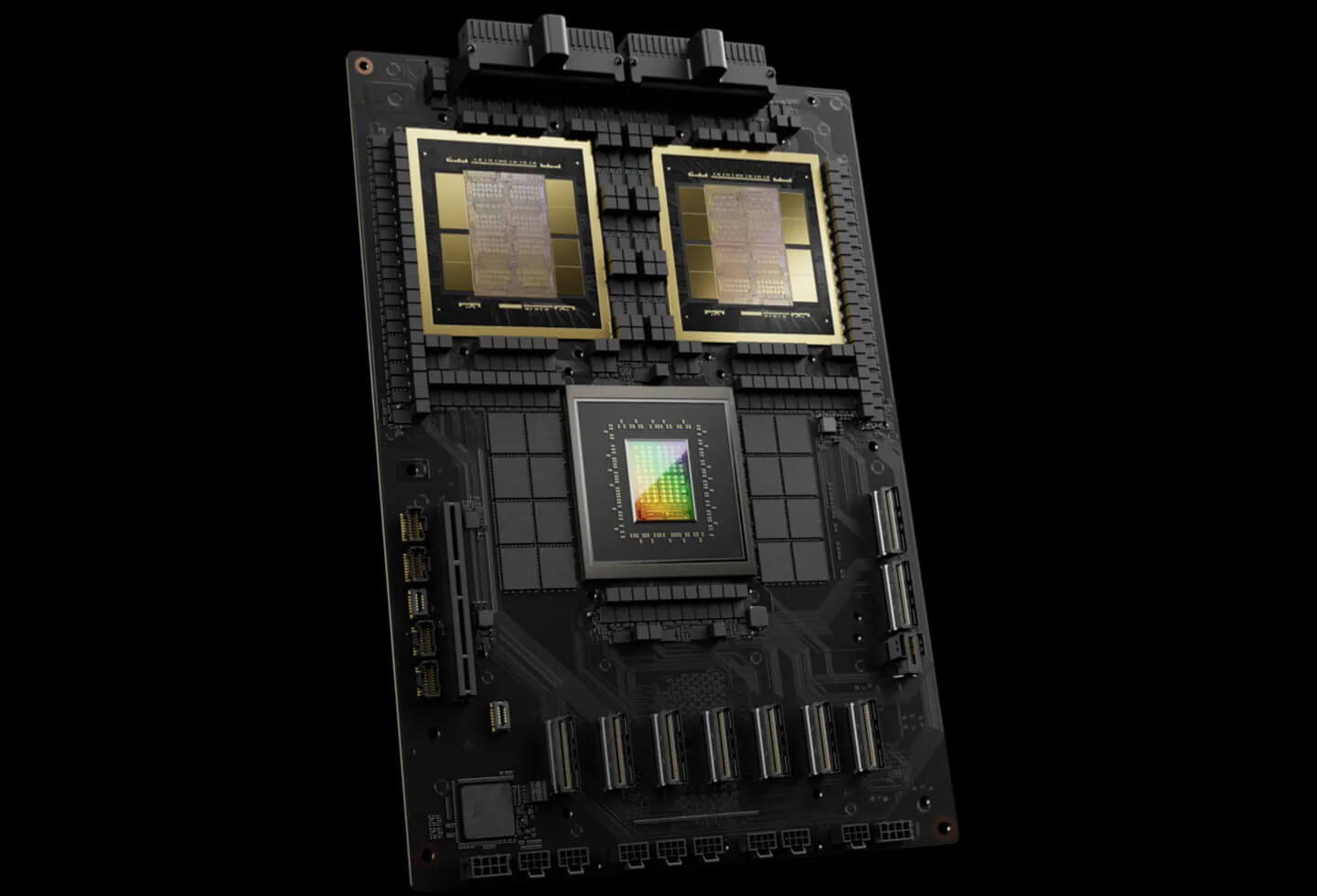

Blackwell 家族中的佼佼者是 B200 GPU,它拥有多达 2080 亿个晶体管,算力高达 20 petaflops。而由两个 B200 GPU 和一个 Grace CPU 组成的"超级芯片"GB200,据称在大语言模型的推理性能上是 H100 的 30 倍,而功耗和成本却只有 H100 的零头。简单来说,如果你想训练一个特别大的语言模型,比如参数量高达 1.8 万亿,以前你得用 8000 个最新的 H100,消耗 15 兆瓦的电力,现在只要 2000 个 B200,4 兆瓦就搞定了。

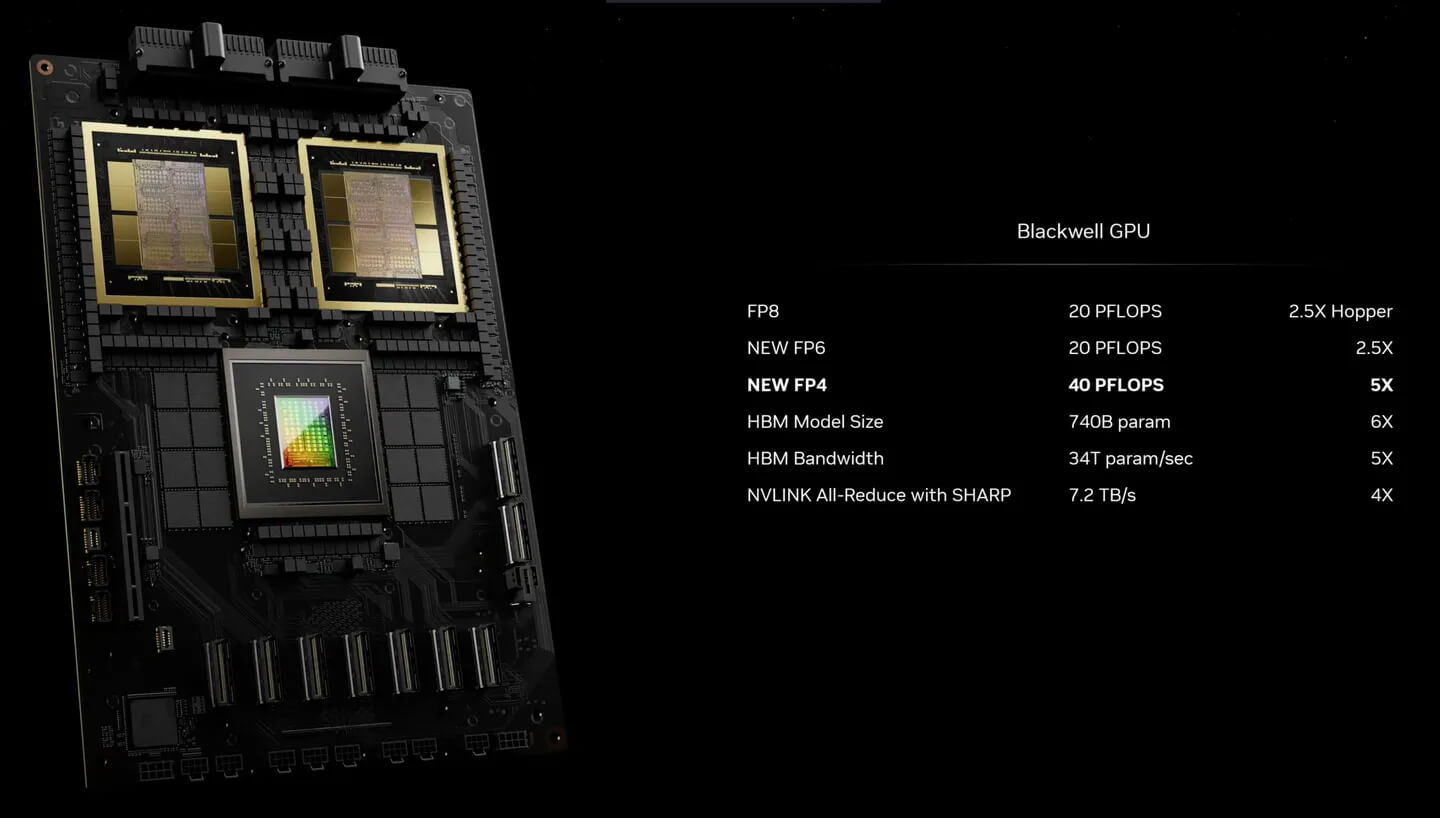

Blackwell 系列芯片在架构上有一些关键的创新。比如第二代 Transformer 引擎,通过每个神经元用 4bit 取代 8bit,芯片的算力、带宽和支持的最大模型尺寸都翻了一番。再比如全新设计的 NVLink 高速互联,576 个 GPU 可以互相通信,带宽高达每秒 1.8TB。这可不是一般的"马路",Nvidia 还专门为此设计了一款网络交换芯片,芯片本身就集成了 3.6 teraflops 的算力,用于调度这些 GPU 之间的通信,大幅提高整体的运算效率。

当然,Nvidia 更希望企业一次性买一大堆 Blackwell GPU 回去,所以还贴心地提供了整机柜的方案。就拿 GB200 NVL72 机柜来说,它把 36 个 CPU 和 72 个 GPU 塞进了一个液冷机柜里,AI 训练算力高达 720 petaflops,推理超过 1.4 exaflops。如果你要训练的是号称有 1.7 万亿参数的 GPT-4,那可能只用得着一个这样的机柜。据说亚马逊、谷歌、微软、甲骨文都在抢着购买这种机柜,看来 Nvidia 这次又要大赚特赚了。

对于我们普通消费者来说,Blackwell 系列可能还要等上一段时间才能惠及我们。但它背后的那些技术创新,很可能会应用到 Nvidia 下一代的 RTX 50 系列游戏显卡上!