Controlnet的作者又放大招!Lvmin Zhang和Maneesh Agrawala发表了一篇题为“使用隐式透明度的透明图像分层扩散”的论文,提出了一种称为“层扩散”(LayerDiffusion)的算法,可以让大规模预训练的隐变量扩散模型生成高质量的透明图像。

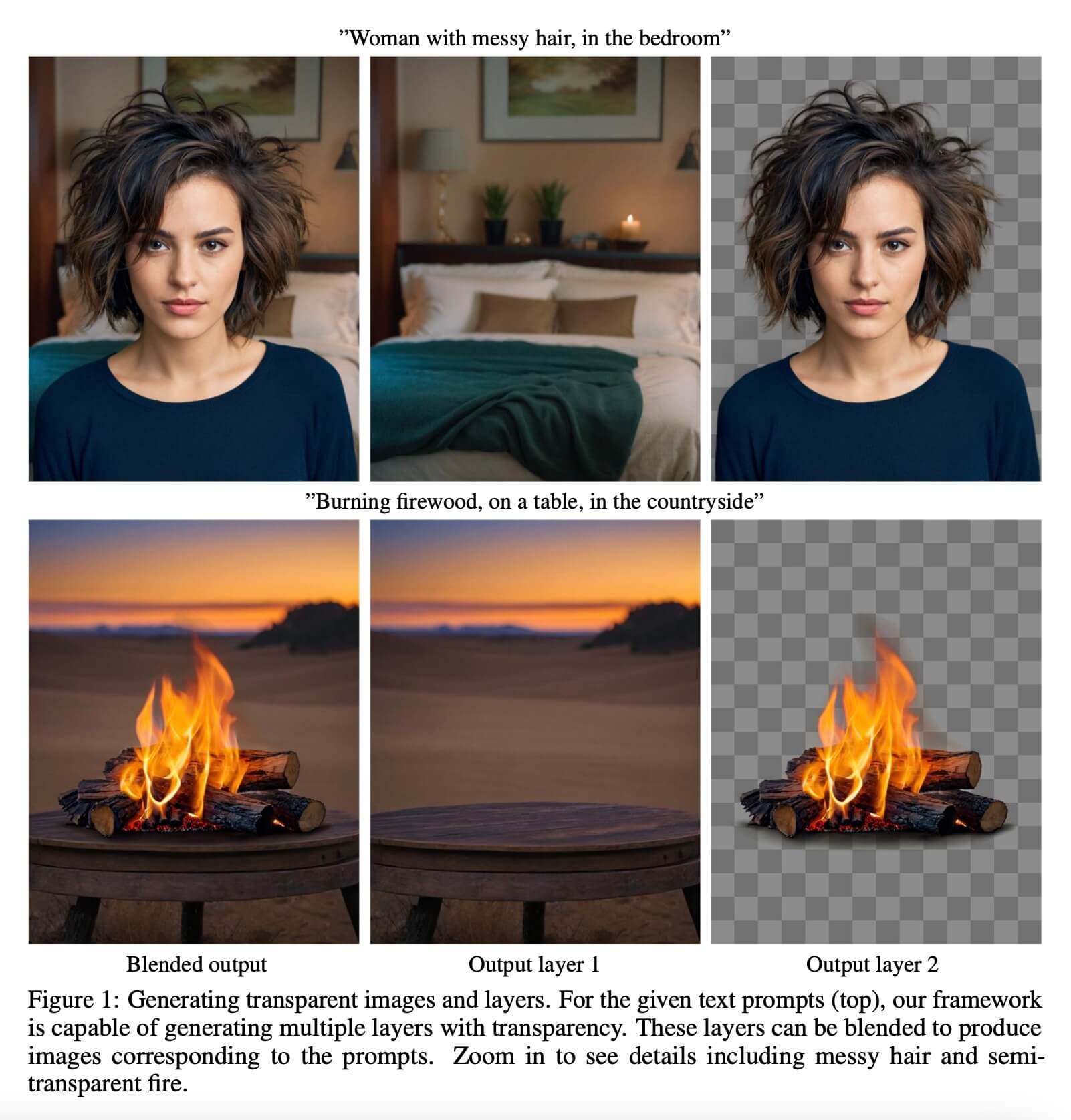

长期以来,主流的AI图像生成模型大多只能输出不透明背景的图像,这限制了生成图片的应用范围和便捷性。设计师和内容创作者需要对图片进行大量后期处理才能去背景,无法直接获得可复用的透明图像。

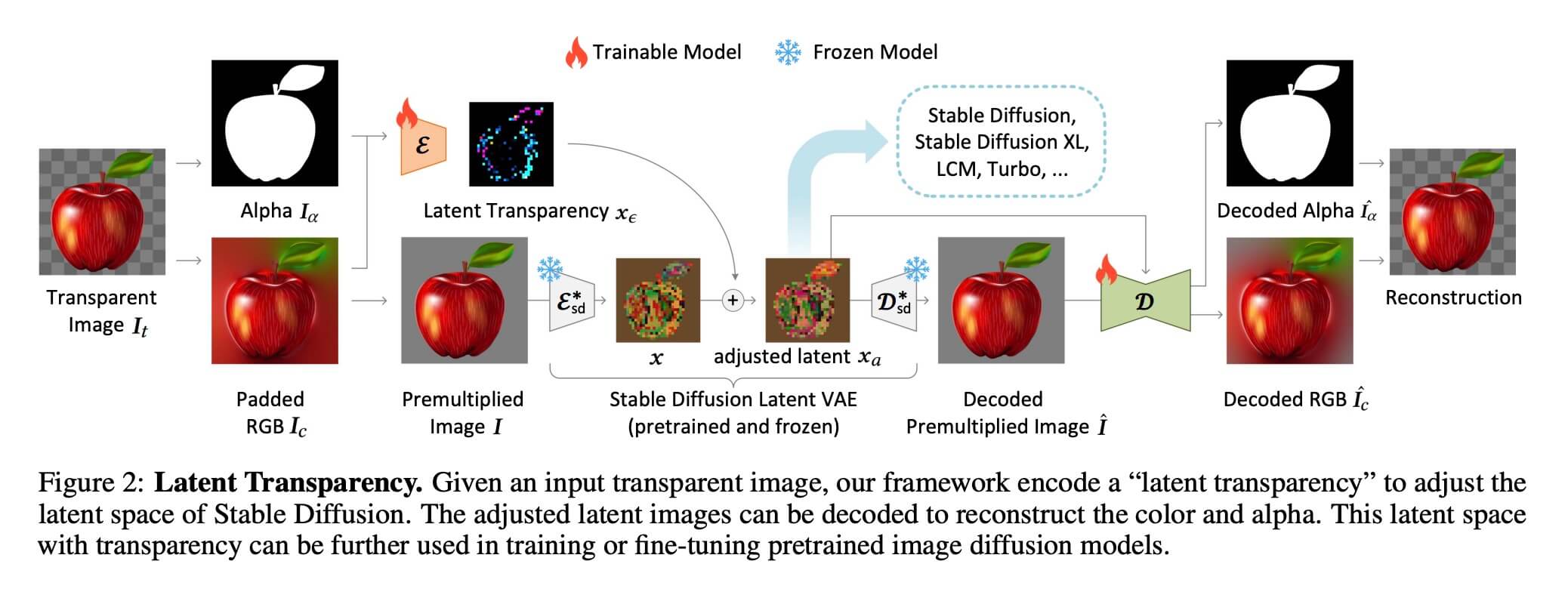

论文作者表示,该算法的关键是学习“隐式透明度”,将alpha通道的透明信息编码到预训练模型的隐空间中。这种方法可以在保留扩散模型生成图像质量的同时,添加透明效果。透明度以隐变量偏移的形式加入,尽可能小地改变原始模型的隐空间分布,避免对模型造成破坏。

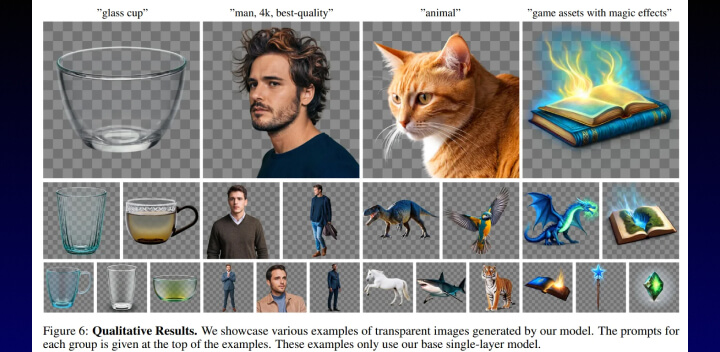

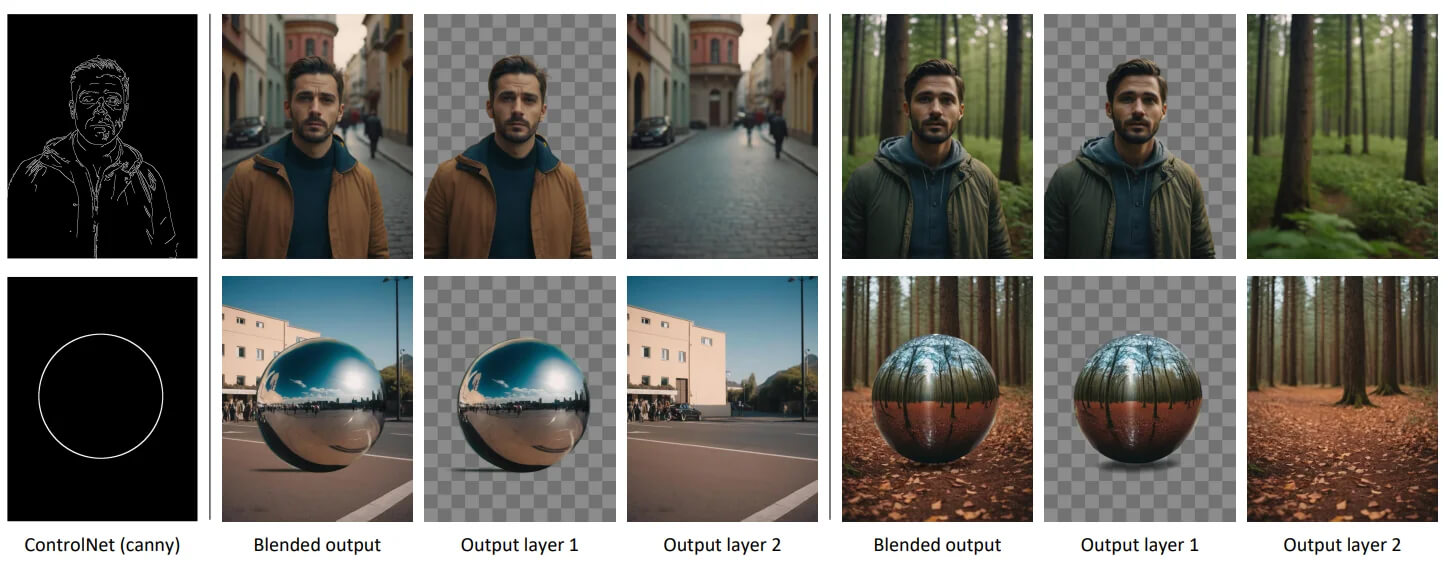

为了训练模型,研究人员收集了100万对透明图像层的数据集,采用了人机交互的方式进行标注。他们展示了层扩散算法可以应用于不同的开源图像生成模型,并可适配各种条件控制系统,实现根据前景背景生成透明层、联合生成多层、控制层的结构等效果。

用户研究表明,与直接生成后再抠图的传统方式相比,受试者更偏爱层扩散算法生成的透明图像质量,认为其可与Adobe Stock等商业透明素材媲美。研究人员期待该算法不仅可用于生成透明图像,也可支持样式迁移等其他应用的研究。

本研究为利用AI算法生成高质量的透明图像提供了一种新方案,也有望推动透明图像在更多场景中的应用,为创作者提供更大便利。

目前,LayerDiffusion还只是一项研究,但已在学术界引起关注。它有望推动创意设计行业进步,为艺术家提供更丰富的创作工具。一旦商业化,设计师可以利用AI直接输出透明背景素材,节省大量手工抠图时间,同时提升图像质量。

尽管还需完善,LayerDiffusion的问世预示着透明图像生成进入新的发展时代!

作者GitHub:https://github.com/lllyasviel