近日,Stability AI发布了开源生成式视频模型Stable Video Diffusion,这是在其开源图像模型Stable Diffusion的基础上开发的第一代生成式视频基础模型。随着该模型的发布,生成式视频模型研究也迎来了新的发展契机。

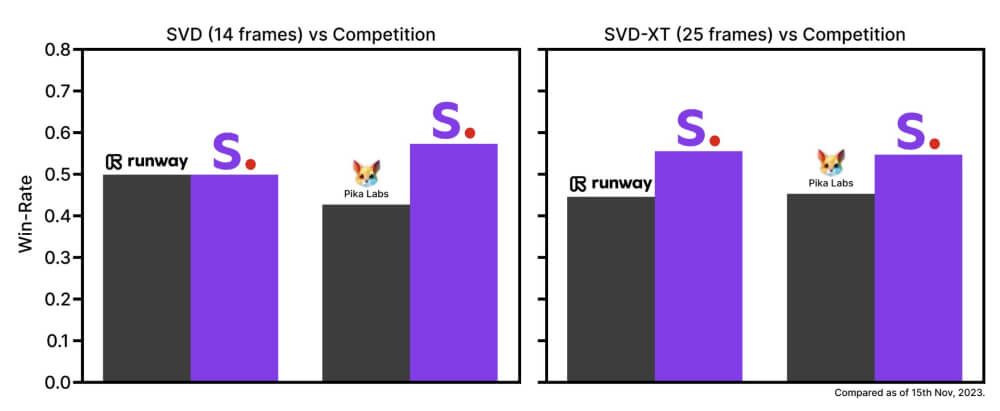

Stable Video Diffusion可生成14帧和25帧的图像到视频模型,帧率可自定义为每秒3至30帧。在发布之初,该模型在用户偏好研究中已超过了当前封闭式领先模型的效果。

具体来说,Stability AI进行的外部评估显示,Stable Video Diffusion在用户偏好研究中胜过了当前闭源的领先模型比如pika labs和runway,这证明了其在生成视频质量上的优势。

Stability AI此次发布同时开源了Stable Video Diffusion的代码和模型权重,开发者可以直接应用到自己的项目中。代码可在Stability AI的GitHub仓库中获取,模型权重可在其Hugging Face页面下载。

这对视频生成领域的研究将是一次巨大的推动,开发者可以基于该模型进行二次开发,创造更多创新应用。

Stable Video Diffusion可广泛应用于各类视频生成任务。仅需微调数据集,该模型就可实现从单张图像生成多视角视频。

例如,在多视角数据集上微调后,可实现从单张图像生成具有多视角的视频。Stability AI计划在这个基础模型之上,打造更多延伸模型,如在Stable Diffusion图像模型周围出现的生态系统。可以预见将会出现针对不同应用优化的视频生成模型。

从Stability AI公布的案例来看,微调后的Stable Video Diffusion可生成逼真流畅的多视角视频。

Stable Video Diffusion的发布标志着生成式视频模型研究进入了一个崭新的阶段。这个开源且性能优异的基础模型为视频生成领域的未来发展提供了可能。我们会看到Stable Video Diffusion的许多创新应用,这将极大拓展视频生成的应用范围。