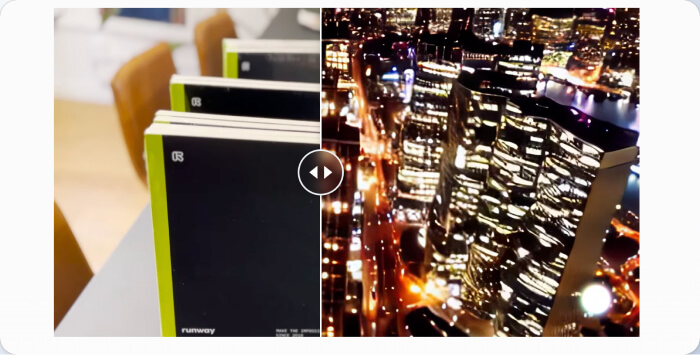

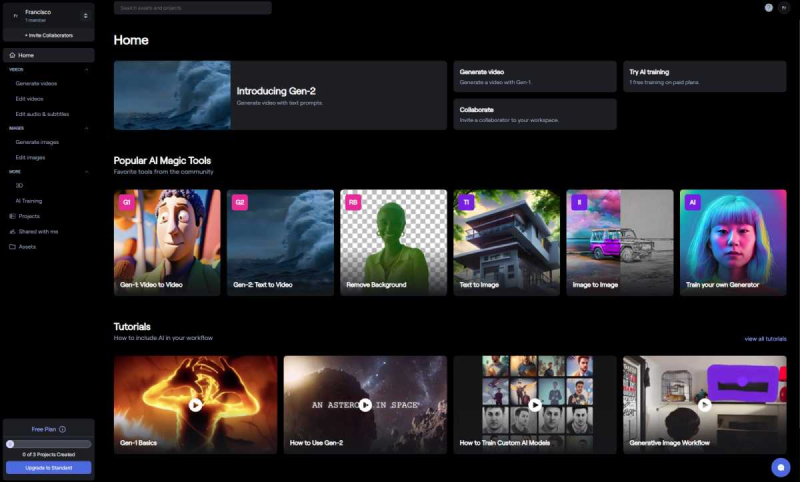

Runway Gen-2模型开放公测,文本生成视频AI来临,Gen-2模型是公司在这条道路上迈出的里程碑式一步,它改变了人们制作和体验视频内容的方式,只需要输入文本就可以生成视频啦!

Gen-2提供八种模式,可以通过不同的输入内容生成视频。

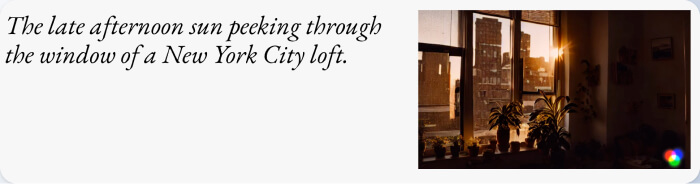

1.“文本到视频”模式

它仅需要输入文本提示,就可以生成任意风格的视频内容,将想象变成现实。如果你可以描述,现在你就可以看到。比如你输入“走在热带雨林里”,它可以生成一段穿梭在热带丛林中的视频。

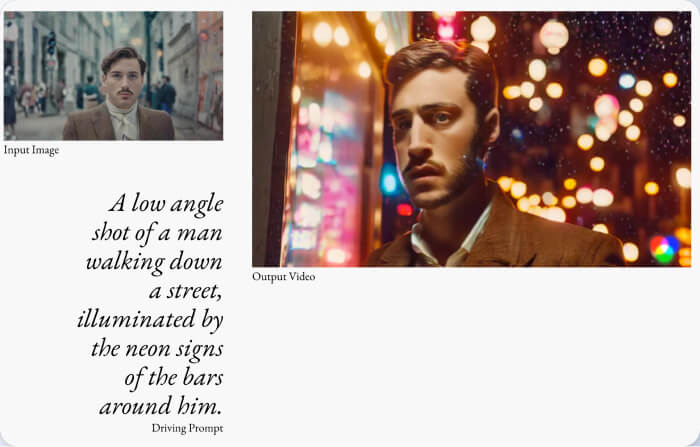

2.“文本+图像到视频”模式

可以使用文本提示和输入图像一起生成视频,就会根据这个图像的基调生成内容丰富的视频。

3.“图像到视频”模式

仅使用输入图像即可生成视频,让静态图像动起来。

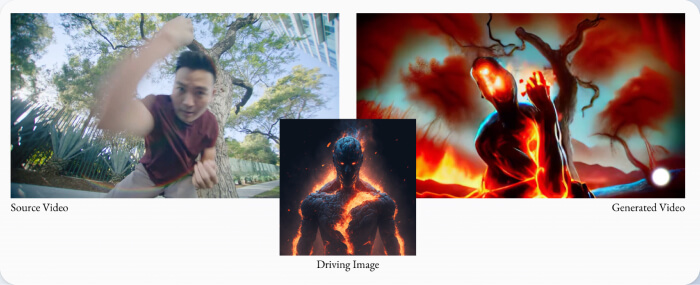

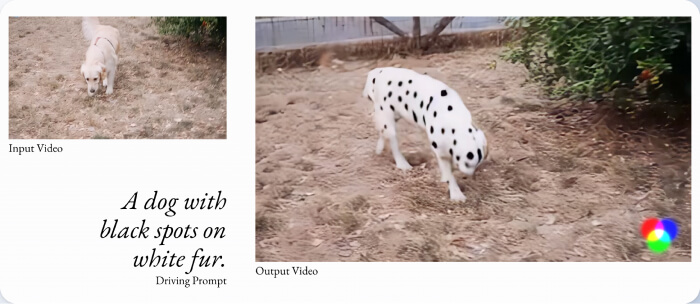

4.“风格转移”模式

它可以将任意图像或文本的视觉风格应用到视频的每一帧,实现视觉上的统一效果。比如使用毕加索的绘画风格来渲染您的视频。

5.“故事板转视频”模式

将原型图转换成具有完整风格和动画效果的渲染画面。

6.“遮罩”模式

它可以识别视频中的目标物体,然后通过简单的文本提示对其进行修改,实现对视频内容的精细控制。比如改变主角衣服的颜色,或者替换视频中出现的产品牌子。

7.“渲染”模式

它可以将无质感的3D渲染图像序列转变为真实的视频输出。

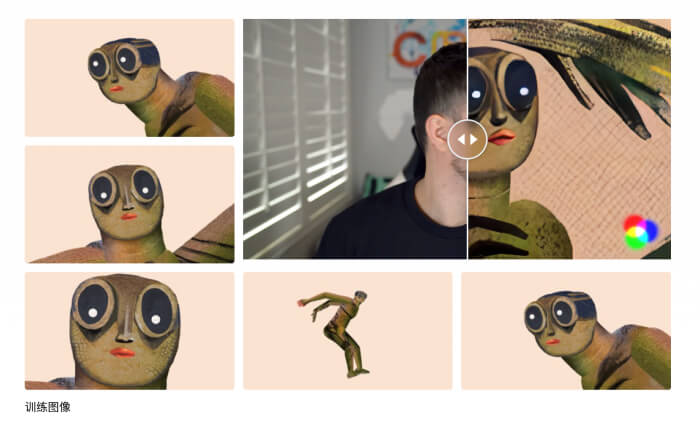

8.“定制”模式

它可以根据用户的具体需求定制模型,获得更高保真度的视频生成结果。用户只需要提供训练数据,Gen-2的定制化功能可以快速学会并满足用户定制的生成需求。

Gen-2模型已初步展示了文本生成视频技术的巨大潜力,它或许还不能完全取代人工完成内容创作,但定会成为一种强大的辅助工具。

如果感兴趣,快去官网体验吧!

http://research.runwayml.com/gen2