Stable diffusion是个开源的AI绘画模型框架,与Midjourney和Dall-e不同,它是免费开源的,值得深入理解。它包含多个模型,这些模型之间存在复杂的关系,理清模型关系有助于我们使用Stable Diffusion web ui进行作业。

1.基础模型(Base Model)

如Stable Diffusion v1.5和v2.0,这是生成图片的基础模型。

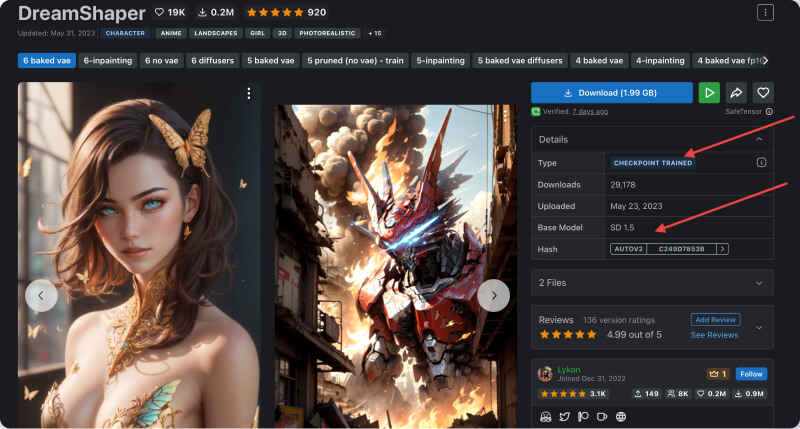

2. 检查点(Checkpoint)

Checkpoint也可以理解为模型,是在基础模型的基础上进行fine-tuning而得到的模型,可以生成更高质量的图片。Checkpoint通常会公开发布,开发者可以选择不同的Checkpoint来使用。

Fine-tuning是机器学习中的重要概念,指的是在预训练模型的基础上进行微调,以适应新的任务或数据集。

在Stable Diffusion中,开发者会选择一个基础模型,然后在该模型的基础上进行fine-tuning,调整模型的参数以生成更高质量的图片,得到的模型就称为“Checkpoint”。

Checkpoint的获得需要提供大量高质量的图片数据集进行训练,训练过程会持续调整Checkpoint模型的参数,最大限度地拟合数据集,这就是fine-tuning的过程。

简单来说,检查点是经过fine-tuning后基础模型的升级版,可以生成更高质量的图片。

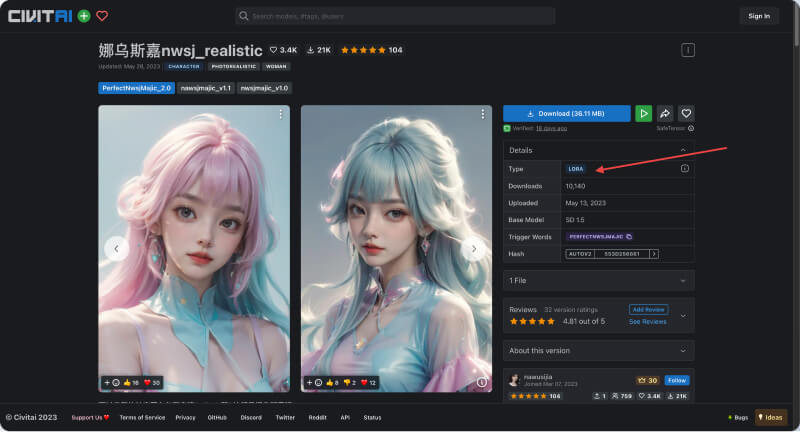

3. 可选模型(Optional Model)

如Lora和Texture Inversion,这些模型可以看作是在基础模型生成的图片上增加“附加”的效果,增强或改变图片的风格。

可选模型也需要训练获得。用于在不修改SD模型的前提下,定制SD模型的生成风格或添加新的人物/IP。

它需要少量数据训练,较易被社区开发者和个人使用。

4. 修补模型(Inpainting Model)

如VAE(变分自动编码器),用于修复图片中的某些部分,例如修复人脸图片中的眼睛,或者可以理解为一种滤镜,修补模型也依赖于训练。

所以,简单来说,Stable Diffusion框架相当于一个“容器”,基础模型是容器的基石,其他模型和修补模型相当于可以自由拼接的“模块”,实现不同的图片生成效果,但无论如何拼接,都需要基础模型作为生成图片的基础。